Видеокарта P106-100: играем на том, что не предназначено для игр

- Цена: ¥470 ≈ $70.2 (без учёта доставки в Россию)

- Перейти в магазин

В разгар криптовалютного бума NVIDIA дала партнёрам «добро» на выпуск специальных видеокарт для майнинга, которые представляют собой упрощённые версии игровых моделей. Ажиотаж майнинга давно прошёл, а видеокарты остались.

Карта заказана 15 января и добралась до меня 8 февраля. В общей сложности, с учётом услуг посредника, пересылки и доставки по России обошлась в $102.45.

Продавец высылает в случайном порядке карты производства MSI, Gigabyte, Galaxy, Colorful и Gengsheng (за пределами Китая известна под брендом Gainward). Мне досталась Gigabyte.

Продавец высылает в случайном порядке карты производства MSI, Gigabyte, Galaxy, Colorful и Gengsheng (за пределами Китая известна под брендом Gainward). Мне досталась Gigabyte.

Судя по сайту производителя, карта поставляется в двух вариантах: без крепёжной планки и с однослотовой планкой. Продавец прикрутил двухслотовую планку, за что ему спасибо, но одного винта пожалел. Пришлось поправить дело синей изолентой.

Судя по сайту производителя, карта поставляется в двух вариантах: без крепёжной планки и с однослотовой планкой. Продавец прикрутил двухслотовую планку, за что ему спасибо, но одного винта пожалел. Пришлось поправить дело синей изолентой.

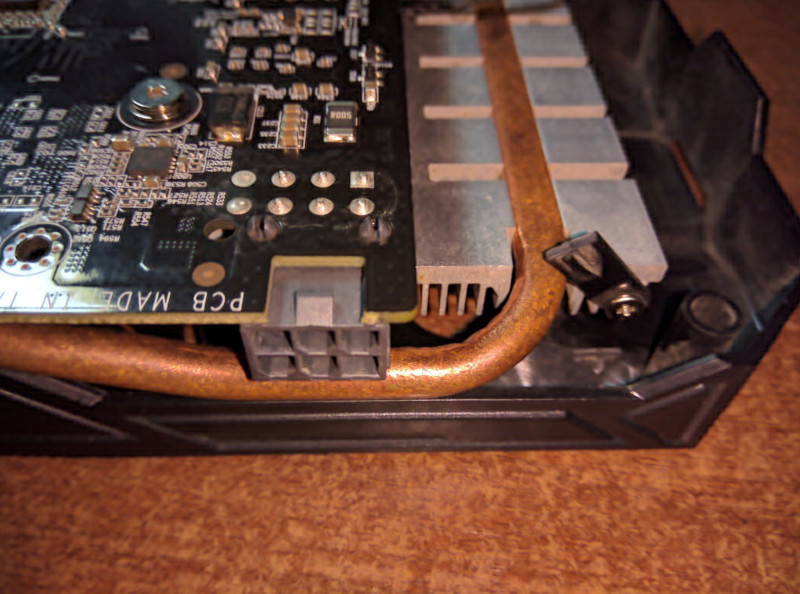

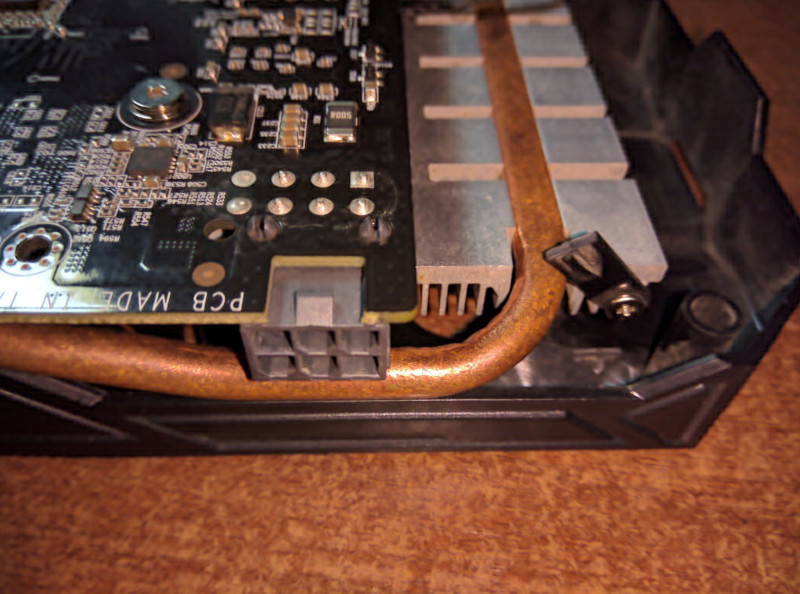

А вот отломанное крепление системы охлаждения так просто не починить:

Впрочем, оставшиеся три крепления держат надёжно.

Впрочем, оставшиеся три крепления держат надёжно.

Дальнейшие действия зависят от поколения процессора.

Дальнейшие действия зависят от поколения процессора.

Тесты проведены на платформе:

Unigine Valley Benchmark 1.0

Render: Direct3D11

Mode: 1920x1080 8xAA fullscreen

Preset: Extreme HD

FPS: 65.7

Score: 2748

Min FPS: 31.9

Max FPS: 125.8

Набранное количество баллов соответствует GTX 1060 6GB.

Unigine Heaven Benchmark 4.0

Render: Direct3D11

Mode: 1920x1080 8xAA fullscreen

Quality: Ultra

Tessellation: Extreme

FPS: 61.7

Score: 1555

Min FPS: 25.5

Max FPS: 125.2

12.5% потеря производительности по сравнению с GTX 1060 6GB.

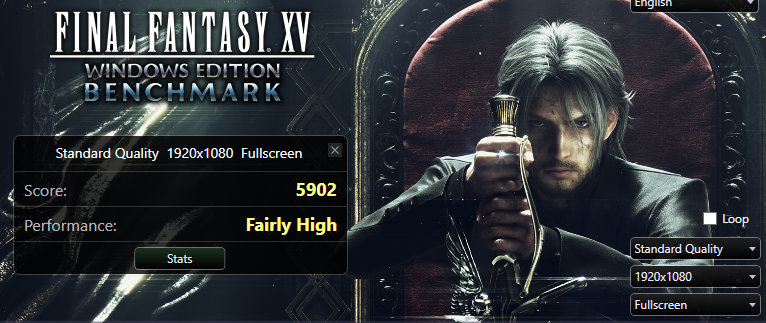

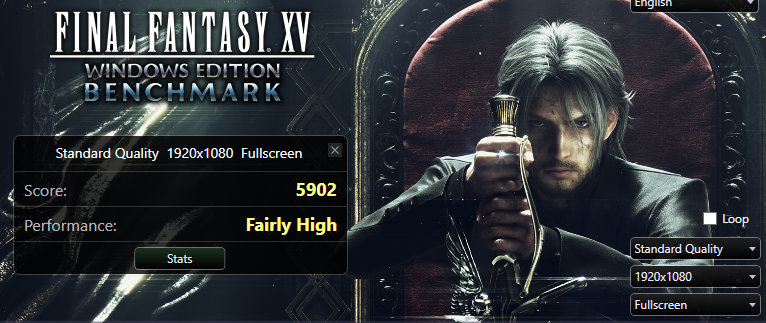

Final Fantasy XV Benchmark

9% и 7% падения производительности соответственно.

9% и 7% падения производительности соответственно.

Возможно, с более производительным процессором и двухканальным режимом работы памяти было бы получше. Также стоит отметить, что технология Ansel работает, поскольку не привязана к GeForce Experience.

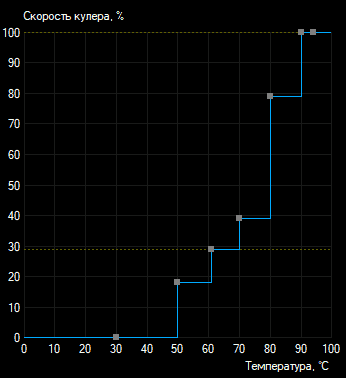

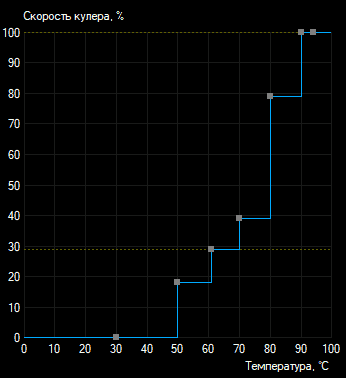

Под нагрузкой проявляется ещё одна особенность карты — она старается удержать температуру графического процессора на отметке 55°. Уровень шума при этом сложно назвать комфортным. Для майнеров это не критично, но мы-то геймеры… Проблема решается одним из двух способов:

способ 1 (на свой страх и риск) — прошить BIOS от аналогичной карты, у которой температурные лимиты выставлены более расслабленно:

способ 2 (безопасный универсальный) — указать желаемую кривую температур в MSI Afterburner:

Минусы

Может не устроить

Поскольку, начиная с Pascal, NVIDIA в обязательном порядке требует наличие цифровой подписи у прошивок, «китайские» карты не имеют какой-то особой, модифицированной прошивки. Следовательно, ничем не отличаются от доступных у нас.

Говорят, что некоторые игры не работают при таком раскладе?

Я лично проверил такие игры как Ведьмак 2, Ведьмак 3, World of Warcraft, Nier: Automata, Metro Exodus, Hearthstone, Star Wars: Battlefront II. Всё работает. Не завёлся только бенчмарк 3DMark.

А если прошить BIOS от 1060 6GB?

Мне удалось пропатчить все проверки в утилите NVFlash, но программно прошить BIOS от другого чипа невозможно, потому что Device ID видеокарты и Device ID прошивки сверяется не только утилитой, но и самим видеочипом. Попытка прошить аппаратным программатором привела к BSOD. Более того, не помогает даже замена платы (т.е. пересадка видеочипа P106-100 на плату от 1060 со всей обвязкой и прошивкой). Таким образом:

Вывод: превратить P106-100 в 1060 невозможно.

Какие ещё есть карты для майнинга?

P106-090 — похожа на GTX 1050 Ti, имеет более широкую шину памяти, большие частоты, но всего 3 гигабайта памяти.

P104-100 — разогнанная GTX 1070 с урезанным вдвое объёмом памяти.

P104-101 — копия GTX 1080.

P102-100 — урезанная версия GTX 1080 Ti с 5 ГБ памяти.

P102-101 — то же самое, но уже с 10 ГБ памяти.

Нужно понимать, что чем мощнее карта, тем больше она будет упираться в шину. Обратите внимание, встречаются карты с шиной, урезанной до PCI-E 1.1 x4! Например, P104-100 производства Gigabyte и P106-90 производства Zotac. Это очень бьёт по производительности.

На всякий случай, привожу идентификаторы этих карт (драйверы модифицируются аналогично):

Да, см. тут и тут. Причём необязательно с GTX 1060. Например, можно поставить GP106-100 в пару с GTX 1070.

Можно ли для вывода изображения использовать дешёвую дискретную видеокарту вместо интегрированного видео?

Единственный вариант использования двух дискретных видеокарт — SLI, описан выше.

Карта заказана 15 января и добралась до меня 8 февраля. В общей сложности, с учётом услуг посредника, пересылки и доставки по России обошлась в $102.45.

Внешний вид

Упаковка

Судя по сайту производителя, карта поставляется в двух вариантах: без крепёжной планки и с однослотовой планкой. Продавец прикрутил двухслотовую планку, за что ему спасибо, но одного винта пожалел. Пришлось поправить дело синей изолентой.

Судя по сайту производителя, карта поставляется в двух вариантах: без крепёжной планки и с однослотовой планкой. Продавец прикрутил двухслотовую планку, за что ему спасибо, но одного винта пожалел. Пришлось поправить дело синей изолентой.А вот отломанное крепление системы охлаждения так просто не починить:

Впрочем, оставшиеся три крепления держат надёжно.

Впрочем, оставшиеся три крепления держат надёжно.Технические характеристики

Идентичны обыкновенной GTX 1060 WINDFORCE 6G за исключением:- отсутствуют видеовыходы

- используется шина PCI-E 1.0/1.1 (у игровых видеокарт — PCI-E 3.0)

- система охлаждения любой ценой старается удержать температуру графического процессора на отметке 55°

- видеоускоритель не определяется как игровой (отсутствует поддержка DirectCompute и PhysX)

Системные требования

- наличие встроенного в процессоре видеоядра

- со слов продавца: не заработает на материнских платах H81/B85/Z87 (т. е. 4 поколения) производства ASUS, а также на более старых платах (но есть обходные пути, о них позже)

- наличие слота PCI-E x16. Версия роли не играет, ведь карта в любом случае работает в режиме 1.1, а вот количество линий очень важно, ведь по шине не только происходит обмен данными с процессором, но и передаётся видеопоток. PCI-E 1.0 x16 по пропускной способности и без того эквивалентна всего лишь PCI-E 3.0 x4. Ещё большее снижение пропускной способности (например, если использовать слот x8) драматически скажется на производительности

Тестовый стенд

Успешная работа подтверждена на системах:- Core i7-6700 ES (разогнан до 3.7 ГГц) + ASUS Z170-P

- Pentium G3420 + Gigabyte GA-H81M-S2PV

- Core i9-9900 ES + Gigabyte Z390M Gaming

Танцы с бубном

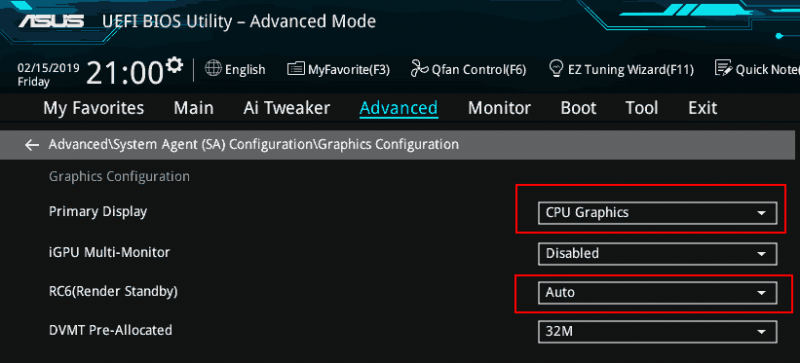

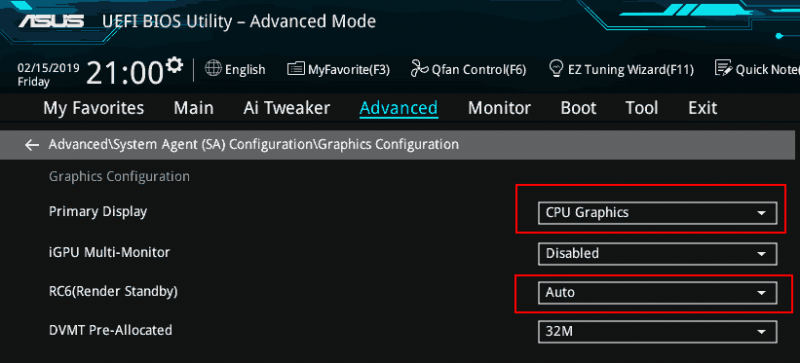

Вставляю карту, подключаю монитор к видеовыходу материнской платы, и… изображение отсутствует. Экспериментальным путём установлено, что требуется изменить пару настроек BIOS, выставив указанные на скриншоте значения: Дальнейшие действия зависят от поколения процессора.

Дальнейшие действия зависят от поколения процессора.AMD APU (Ryzen G, Athlon GE, A10 и прочие), а также Intel поколения Haswell и новее

Windows 10

Начиная с Windows 10 1803, Microsoft реализовала подобие технологии Optimus, знакомой владельцам ноутбуков. Рендеринг в тяжёлых приложениях осуществляет дискретная видеокарта, а за вывод изображений и обработку 2D отвечает встроенное видеоядро процессора. Видеопоток передаётся по шине PCI-E, выводится через видеовыход материнской платы.

Нужно установить графический драйвер на процессорное видеоядро. Обладатели Intel могут воспользоваться приложением Driver & Support Assistant, а для владельцев AMD предназначены драйверы Adrenalin.

Кроме того, придётся модифицировать драйвер NVIDIA.

Во-первых, отключаем автоматическое обновления драйверов через Windows Update. В противном случае рано или поздно там появится более свежий драйвер, который будет автоматически установлен.

Во-вторых, устанавливаем драйвер:

Скачиваем модифицированные файлы с моего гитхаба, а также оригинальный драйвер с сайта NVIDIA (версия драйвера, разумеется, должна совпадать). Распаковываем драйвер с помощью архиватора (7-Zip или WinRAR) и заменяем файлы поверх.

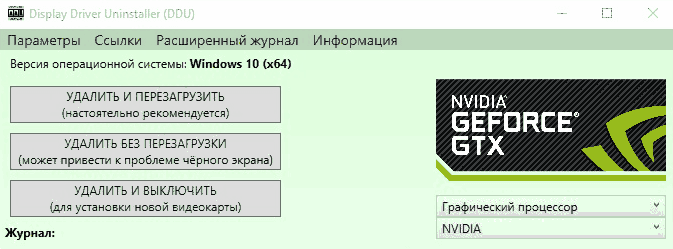

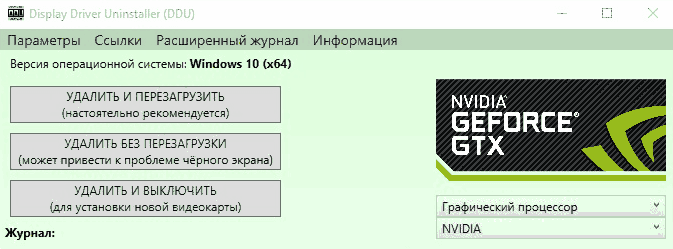

После этого, скачиваем Display Driver Uninstaller, отключаем сетевой адаптер (или вытаскиваем сетевой кабель). Запускаем DDU, чистим систему от драйверов NVIDIA (выбрав очистку с перезагрузкой):

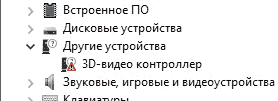

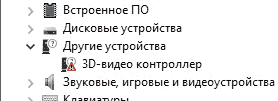

После автоматической переагрузки заходим в диспетчер устройств и выполняем «Действие» → «Обновить конфигурацию оборудования». Необходимо добиться того, чтобы вместо дискретной видеокарты отображался «3D-видео контроллер»:

После автоматической переагрузки заходим в диспетчер устройств и выполняем «Действие» → «Обновить конфигурацию оборудования». Необходимо добиться того, чтобы вместо дискретной видеокарты отображался «3D-видео контроллер»:

Запускаем Install.bat с правами администратора и устанавливаем драйвер.

Возвращаем обратно интернет и перезагружаемся.

Заходим в панель управления NVIDIA (значок в трее) и выставляем нашу видеокарту в качестве предпочтительного графического процессора, чтобы игры по умолчанию использовали именно её.

Если теперь запустить GPU-Z, то он сообщит, что у карты появилась поддержка DirectCompute (если вам нужен ещё и PhysX, то установите его):

Нужно установить графический драйвер на процессорное видеоядро. Обладатели Intel могут воспользоваться приложением Driver & Support Assistant, а для владельцев AMD предназначены драйверы Adrenalin.

Кроме того, придётся модифицировать драйвер NVIDIA.

Во-первых, отключаем автоматическое обновления драйверов через Windows Update. В противном случае рано или поздно там появится более свежий драйвер, который будет автоматически установлен.

Windows Registry Editor Version 5.00

[HKEY_LOCAL_MACHINE\SOFTWARE\Policies\Microsoft\Windows\WindowsUpdate]

"ExcludeWUDriversInQualityUpdate"=dword:00000001Во-вторых, устанавливаем драйвер:

Скачиваем модифицированные файлы с моего гитхаба, а также оригинальный драйвер с сайта NVIDIA (версия драйвера, разумеется, должна совпадать). Распаковываем драйвер с помощью архиватора (7-Zip или WinRAR) и заменяем файлы поверх.

После этого, скачиваем Display Driver Uninstaller, отключаем сетевой адаптер (или вытаскиваем сетевой кабель). Запускаем DDU, чистим систему от драйверов NVIDIA (выбрав очистку с перезагрузкой):

После автоматической переагрузки заходим в диспетчер устройств и выполняем «Действие» → «Обновить конфигурацию оборудования». Необходимо добиться того, чтобы вместо дискретной видеокарты отображался «3D-видео контроллер»:

После автоматической переагрузки заходим в диспетчер устройств и выполняем «Действие» → «Обновить конфигурацию оборудования». Необходимо добиться того, чтобы вместо дискретной видеокарты отображался «3D-видео контроллер»:

Запускаем Install.bat с правами администратора и устанавливаем драйвер.

Возвращаем обратно интернет и перезагружаемся.

Заходим в панель управления NVIDIA (значок в трее) и выставляем нашу видеокарту в качестве предпочтительного графического процессора, чтобы игры по умолчанию использовали именно её.

Если теперь запустить GPU-Z, то он сообщит, что у карты появилась поддержка DirectCompute (если вам нужен ещё и PhysX, то установите его):

Linux

Устанавливаем проприетарный видеодрайвер NVIDIA из репозиториев, а также Steam/Lutris/Wine. Всё работает «из коробки».

Windows 7

На форуме LTT предложили такое решение:

To force vga output in Windows 7 you need to go to the «Screen resolution» menu, click on «Detect» button — another gray screen(s) should pop up in the menu. Click on one of them, and in the drop down menu select something like «Try to connect VGA display on P106-100»

After that select «Extend Displays» and apply

Then if you set your «virtual monitor» as a Default (Don't do this unless you have a program to switch windows between monitors with keys!!! I use Ultramon) program will start there and use the P106-100 GPU and you can use your hotkey to switch to your main monitor and it will be good»

To force vga output in Windows 7 you need to go to the «Screen resolution» menu, click on «Detect» button — another gray screen(s) should pop up in the menu. Click on one of them, and in the drop down menu select something like «Try to connect VGA display on P106-100»

After that select «Extend Displays» and apply

Then if you set your «virtual monitor» as a Default (Don't do this unless you have a program to switch windows between monitors with keys!!! I use Ultramon) program will start there and use the P106-100 GPU and you can use your hotkey to switch to your main monitor and it will be good»

Intel поколения Ivy Bridge и старее

Учтите, что поддержки DX12 у вас не будетLinux

Возможно, всё будет работать «из коробки» после установки проприетарного видеодрайвера NVIDIA из репозиториев. Пока никто не проверял.

Windows 7

На форуме LTT предложили такое решение, но пока никто не проверял его со старыми процессорами:

To force vga output in Windows 7 you need to go to the «Screen resolution» menu, click on «Detect» button — another gray screen(s) should pop up in the menu. Click on one of them, and in the drop down menu select something like «Try to connect VGA display on P106-100»

After that select «Extend Displays» and apply

Then if you set your «virtual monitor» as a Default (Don't do this unless you have a program to switch windows between monitors with keys!!! I use Ultramon) program will start there and use the P106-100 GPU and you can use your hotkey to switch to your main monitor and it will be good»

To force vga output in Windows 7 you need to go to the «Screen resolution» menu, click on «Detect» button — another gray screen(s) should pop up in the menu. Click on one of them, and in the drop down menu select something like «Try to connect VGA display on P106-100»

After that select «Extend Displays» and apply

Then if you set your «virtual monitor» as a Default (Don't do this unless you have a program to switch windows between monitors with keys!!! I use Ultramon) program will start there and use the P106-100 GPU and you can use your hotkey to switch to your main monitor and it will be good»

Тестирование

Поскольку карта идентична по характеристикам обычной GTX 1060 6GB, то единственный вопрос, который интересует — падает ли производительность из-за низкой пропускной способности шины PCI-E 1.0.Тесты проведены на платформе:

- Core i7-6700 ES @ 3.7 ГГц

- ASUS Z170-P

- 16 ГБ DDR4-2133 в одноканальном режиме

Unigine Valley Benchmark 1.0

Render: Direct3D11

Mode: 1920x1080 8xAA fullscreen

Preset: Extreme HD

FPS: 65.7

Score: 2748

Min FPS: 31.9

Max FPS: 125.8

Набранное количество баллов соответствует GTX 1060 6GB.

Unigine Heaven Benchmark 4.0

Render: Direct3D11

Mode: 1920x1080 8xAA fullscreen

Quality: Ultra

Tessellation: Extreme

FPS: 61.7

Score: 1555

Min FPS: 25.5

Max FPS: 125.2

12.5% потеря производительности по сравнению с GTX 1060 6GB.

Final Fantasy XV Benchmark

9% и 7% падения производительности соответственно.

9% и 7% падения производительности соответственно.Возможно, с более производительным процессором и двухканальным режимом работы памяти было бы получше. Также стоит отметить, что технология Ansel работает, поскольку не привязана к GeForce Experience.

Под нагрузкой проявляется ещё одна особенность карты — она старается удержать температуру графического процессора на отметке 55°. Уровень шума при этом сложно назвать комфортным. Для майнеров это не критично, но мы-то геймеры… Проблема решается одним из двух способов:

способ 1 (на свой страх и риск) — прошить BIOS от аналогичной карты, у которой температурные лимиты выставлены более расслабленно:

- находим на TechPowerUp подходящий BIOS. Чтобы увидеть прошивки для P106-100, нужно в графе «GPU Brand» выбрать «Unverified Uploads», а «Card Model» выбрать «P106-100»

- при выборе прошивки внимательно смотрите, чтобы совпадал объём памяти (6 ГБ) и чтобы в «Memory Support» поддерживался производитель памяти, распаянной на конретно вашей карте

- перебором удалось найти более старый BIOS. В нём прописаны вполне вменяемые скорости вращения вентиляторов

- BIOS прошивается с помощью NVFlash командами

без ключа "--overridesub" утилита откажется прошивать, поскольку в старом биосе производителем указана Gigabyte, а в новом — NVIDIAnvflash --protectoff nvflash 213313.rom --overridesub - при успехе перезагружаемся и повторяем манипуляции с установкой драйвера и правкой реестра

способ 2 (безопасный универсальный) — указать желаемую кривую температур в MSI Afterburner:

Заключение

Плюсы- Цена

- Выводит изображения на VGA-мониторы. Как известно, у карт поколения Pascal отсутствует поддержка вывода аналогового видеосигнала, что вынуждает приобретать активный конвертер цифрового сигнала в аналоговый. В нашем случае этим занимается материнская плата

- Возможность сказать «NVIDIA, fuck you!»

Минусы

Проблемы с античитами в некоторых многопользовательских играхна январь 2023 года проблемы с античитами решены- Не работает аппаратный кодировщик видео NVENC (то есть, если вы, допустим, хотите записывать или стримить экран через OBS Studio, нужно запускать игру на дискретной видеокарте, а для ускорения кодирования использовать Intel Quick Sync / AMD AMF). По той же причине не работают примочки NVIDIA наподобие ShadowPlay

- Не работают некоторые программы, выводящие оверлей поверх 3D-приложений (FRAPS и т.п.). Другие (допустим, оверлей Steam) умудряются как-то работать

Может не устроить

- Карта побывала в майнинге. С другой стороны, покупая видеокарту «с рук» вы не можете быть уверены в обратном, а продавец будет мамой клясться, что карта «не бита, не крашена, не майнила»

- Требуется редакция Windows не ниже Professional (все способы, ориентированные на Home, у меня не сработали)

FAQ

Обязательно ли заказывать из Китая?Поскольку, начиная с Pascal, NVIDIA в обязательном порядке требует наличие цифровой подписи у прошивок, «китайские» карты не имеют какой-то особой, модифицированной прошивки. Следовательно, ничем не отличаются от доступных у нас.

Говорят, что некоторые игры не работают при таком раскладе?

Я лично проверил такие игры как Ведьмак 2, Ведьмак 3, World of Warcraft, Nier: Automata, Metro Exodus, Hearthstone, Star Wars: Battlefront II. Всё работает. Не завёлся только бенчмарк 3DMark.

А если прошить BIOS от 1060 6GB?

Мне удалось пропатчить все проверки в утилите NVFlash, но программно прошить BIOS от другого чипа невозможно, потому что Device ID видеокарты и Device ID прошивки сверяется не только утилитой, но и самим видеочипом. Попытка прошить аппаратным программатором привела к BSOD. Более того, не помогает даже замена платы (т.е. пересадка видеочипа P106-100 на плату от 1060 со всей обвязкой и прошивкой). Таким образом:

- идентификатор карты намертво вшит в видеочип (изменить его по понятным причинам невозможно)

- чип отказывается работать при несовпадении идентификаторов чипа и прошивки (поэтому с прошивкой от 1060 он не заработает)

- изменить идентификатор в прошивке невозможно, начиная с Pascal, прошивки имеют цифровую подпись, при нарушении которой чип также отказывается работать (поэтому не получится взять прошивку от 1060 и перебить идентификатор, чтобы разблокировать все возможности 1060)

Вывод: превратить P106-100 в 1060 невозможно.

Какие ещё есть карты для майнинга?

P106-090 — похожа на GTX 1050 Ti, имеет более широкую шину памяти, большие частоты, но всего 3 гигабайта памяти.

P104-100 — разогнанная GTX 1070 с урезанным вдвое объёмом памяти.

P104-101 — копия GTX 1080.

P102-100 — урезанная версия GTX 1080 Ti с 5 ГБ памяти.

P102-101 — то же самое, но уже с 10 ГБ памяти.

Нужно понимать, что чем мощнее карта, тем больше она будет упираться в шину. Обратите внимание, встречаются карты с шиной, урезанной до PCI-E 1.1 x4! Например, P104-100 производства Gigabyte и P106-90 производства Zotac. Это очень бьёт по производительности.

На всякий случай, привожу идентификаторы этих карт (драйверы модифицируются аналогично):

- 1C09 = «NVIDIA P106-090»

- 1B87 = «NVIDIA P104-100»

- 1BC7 = «NVIDIA P104-101»

Да, см. тут и тут. Причём необязательно с GTX 1060. Например, можно поставить GP106-100 в пару с GTX 1070.

Можно ли для вывода изображения использовать дешёвую дискретную видеокарту вместо интегрированного видео?

Единственный вариант использования двух дискретных видеокарт — SLI, описан выше.

Самые обсуждаемые обзоры

| +35 |

1490

30

|

| +47 |

2362

91

|

| +97 |

3207

94

|

За обзор — Плюс и Спасибо!

Ну так то у нас переферия, в московии дешевле есть наверняка предложения…

Есть много вариантов с гарантией год полтора.

AMD дешевле, рх470, рх480, рх570 от 2тыс грн идут.

Есть и с гарантией.

Порадовало одно объявление:… в наличии 60 штук :)

Фермы фсё!

з.ы. Вот такие перлы встречаются в объявлениях.

За те же деньги можно взять обозреваемую P106, которая порвёт эту 670 в клочья.

https://gpu.userbenchmark.com/Compare/Nvidia-GTX-1060-3GB-vs-Nvidia-GTX-1060-6GB/3646vs3639

Но vizerkharkiv не прав для России, у нас 1060 3гб от 9 -10 тысяч за карту которая одна в чеке и с гарантией года на 2-3. ( ну и не с майнинга)

Не с майнинга… а как проверить? Я лично видел человека, который уверял, что карты у него не с майнинга, а заходишь в профиль посмотреть его лоты: пяток видеокарт, блок питания на киловатт с лишним, материнка, процессор Celeron. Ну ничуть не остатки фермы, ага.

3х месяцев достаточно чтобы израсходовать 3х летний ресурс жизни бытовой видеокарты.А 1 мес достаточно чтобы её пережечь.

Я у вас точно и за 10 долларов не куплю.

У меня таких стопочка на утилизацию и разборку лежит.

Сгорит через месяц у купившего.Или не сгорит, как повезёт.

А технические аргументы есть?

Суть в том что производиртель расчитывает срок работы бытовой игровой карты по деньгам.

В среднем конечно.Примерно от 3, до 5 лет ранее.

У большинства игроков отработает 3 года, у меньшинства 1 год и 5 или 8 лет.

Кому она нужна через 8 лет????

Ваш Кэп Очевидный.

Бытовая это 7 дней в неделю 5 часов.Бизнес 8 часов 5 дней в неделю.

Пром 24 часа круглый год с перерывом на обслуживание.

Материалы, конструкция и охлаждение и цена ВСЁ разное.

Вы считаете капиталиста идиотом что продаёт вам пром оборудование по бытовой цене?

Что ещё не понятно?

1. деградация кристала

2. что 90% чаще — просто отпадание микросхемы с платы.

«3х месяцев достаточно чтобы израсходовать 3х летний ресурс жизни»

соответственно 24 месяца = 24 года, ну и так далее)

чек выцвел

подарили

покупал брату другу

болею денег надо

больше в игры не играю

майнеры =)

А вы юморист, можно было ещё над плитой примотать

Даже после майнинга бывают нормальные карты.

Я бы даже сказал что после игрулек вероятность подыхания больше… В связи с тем что плата нагревается и потом остывает, и так «каждый день», шарики припоя могут потрескаться, чип отойти…

У меня вот тоже была ситуация, играл мало, видюхе 8 лет было, но в один прекрасный момент запускаю игру и комп повис, перезагружаю, на экране полосы.

Так что умереть может в любой момент.

Побойтесь бога! Мало кому так везёт.

Года 3 назад начала полосить — в духовку + поменял кондеры — работает как новая.

Худшее что может случиться — кулер забился и крутится туго или не крутится или шумит. Если температура была нормальная значит чип не отвалился — значит тесты при покупке пройдет нормально. Радиодетали при работе своей никак не устают и не портятся.

С учетом того, что карты покупаются через оптовые конторы, есть возможность задним числом сделать их накладную с 1й картой в чеке и гарантией, а чеки у нас не всегда дают и при рознице

ну и смысл?!

баксов 20 цена этой игрушке.

В общем, сравнивайте сами, а не слушайте, прости господи, блогеров. Вверху справа 1066, внизу P106-100

Конечно, лучше доплатить 50$-100$, чтобы увидеть эти 3-5 fps из 100 на PCI-E 3.1. (сарказм)

ru.gecid.com/video/testirovanie_nvidia_geforce_gtx_1060_3gb_i_sravnenie_3gb_vs_6gb/

Соответственно, в 6-гигабайтной версии сам чип более производительный. Такой же стоит и в P106-100.

купил себе 1060 3гига, меньше месяца назад за 2к грн!

5 выходов

с пломбами. вид как у новой!

пс я вот честно почитал, понял ещё меньше чем в обзорах кирича

Информация о модели находится в середине обзора.

Понятно, что зависит от остального железа, но может есть минимум?

У меня блок на 550 честных ватт, держит процессор в разгоне и GTX 670 (которая стояла до этого, а она жрёт побольше, чем 1060).

Остальное вы просто приплюсуете на калькуляторе исходя из железа, что у вас будет в системном блоке. Иначе никак не посчитать, если не знать конфигурацию ПК. Ну можно на вскидку посоветовать, как сделали выше, но это всё индивидуально. 450-500 ватт вам должно хватать для обычной конфигурации с небольшим запасом.

Моя 1060 на 120 ватт от блочка с mini atx запитывается, а там ни более 300 ватт. Карточке хватает.

А вот попытка запустить тест 3DMark заканчивалась ошибкой. Спасибо, что напомнили, этот момент я собирался упомянуть в FAQ, но забыл.

Но не факт, что у человека, который задал вопрос, сойдутся звёзды и конфигурация окажется подходящей.

Проинформирован, а далее ему решать, сколько он переплатил и сэкономил времени и избавится от внезапных проблем.

Я тоже хотел такую карту, но цены были от 100$. Поэтому решил не рисковать, а взял рабочий вариант и пусть на 3гб, но за вполне адекватную цену 6500.

А вот прошить в неё биос от 1060 можно (я не рискнул), в сети гуляет прошивальщик от NVIDIA, пропатченный, чтобы не ругался на попытку зашить биос от одной модели в совсем другую.

Но вряд ли от этого отрастут фичи типа ShadowPlay, потому что драйвер всё равно видит, что это не 1060 (это определяет комбинация резисторов)

Вшить подписанный и нетронутый биос от одной карты в другую можно, но только программатором, поскольку в программный прошивальщик NVIDIA встроила защиту от такого финта. Для Turing умельцы это ограничение обошли, а вот для Pascal нет.

youtu.be/9gvgWXFpacM

(Вкратце: ничего не получилось)

Достаточно профессионально и подробно все разобранно в видео.

Если

, то делайте сами бесплатно.

Можете даже свой мелкий бизнес открыть, и за 600 руб. перепаивать. Если выживете с такой ценой — почему бы и нет?

«Сколько заменить микрофон?»

— 600 рублей…

Поехал в типа «ЧиД», купил паяльник с керамическим жалом (сейчас на работе у меня), канифоль, припой, сам микрофон, за всё 450 руб отдал. Заменил.

Ещё пример. Год не помню, был в Москве проездом, зашёл на Митьку — заменить на PS лазер. Запросили 2000 руб за работу + запчасти. Спустился на этаж, купил за 850 рублей лазер, Замена заняла 15 минут. До сих пор работает.

А эти «мастера» живут по одному принципу — «лучше за рубль лежать, чем за два бежать», отсюда и цены такие

И зачем её крутить «каждые выходные»?? — Это уже от того, что дома делать нечего и жена осто… ла… — Ну, этот вариант, надеюсь, мы не рассматриваем?

И может Вы подскажете, какой среднестатистический россиянин зарабатывает 8 тр в час? Я вот зарабатываю 6 тр в день, и мне съэкономить 2 тр за 15 минут вообще то совсем не лишне…

вы типа средне статистический Москвич?

экономите 2тыщи раз в 4 года?

верим. верим.

А Вы, стесняюсь спросить, с какой целью интересуетесь?

Я обычный электромонтер и график работы у меня как у всех — 365-(52*2 + остальные праздники + отпуск(если есть)), посчитайте, если не затруднит.

То, что Вы читать умеете — хорошо, без чтения сейчас трудновато будет. Только чтение без понимания прочитанного — дело неблагодарное.

Я писал «какой среднестатистический россиянин зарабатывает 8 тр в час? Я вот зарабатываю 6 тр в день» — отсюда совсем не следует, что я считаю свой заработок среднестатистическим

Ещё я писал «был в Москве проездом, зашёл на Митьку». Откуда Вы взяли, что я

Когда я писал про «среднестатистического россиянина», я имел в виду ремонтника на Митьке, заломившего 2 тр за 15 минут работы.

Нет, гораздо больше и чаще. 2 тр — это был пример жлобства ремонтников, такое редко встречается. А у меня только кешбек на Алике за прошлый год 90$.

Дело Ваше, только к чему столько сарказма?

у кого мало денег и много свободного времени, тот меняет сам.

у кого много денег и мало свободного времени, тот отдает мастерам.

у кого мало денег и мало свободного времени, тот ничего не делает.

у кого много денег и много свободного времени, тот покупает новый.

Продавать-то можно, как новую получишь с гарантии. Я ведь не говорю, продавать отремонтированную после майнинга, как новую.

т.е. свистящие дроселями видеокарты, которые не хотят принимать по гарантии, это нормально. Вы за кого вообще, за народ или за барыг, задирающих цены?

Так что я не имел ввиду на**ки людей, а вот корпорации которые поднимают цены на свои поделки да, попытаться намахать милое дело.

Наоборот получиться, что человек купит новую видюху дешевле магазинной цены, причем новую.

P.S. А вообще статей по конкретным видеокартам у них на сайте много, так что перед тем как их покупать советую ознакомиться как они их «гробят», а потом наводят на них «марафет» перед продажей. ==> Видео.

— у неподдерживаемых карт (1060)

— у карт с разными GPU (т.е. можно воткнуть даже две карты разного поколения)

Это чисто программное ограничение.

Если кто-то реально будет это делать, я могу подписать дровину.

Хочу сыну (7 лет) поменять комп. Кто что скажет по этой железяке?

KOTIN GB-1/intel i5-8500/8G DDR4/GTX1050TI-4G/ 120G M.2 SSD + 1 ТБ HDD/Dos

Или лучше дома смотреть? У нас из магазинов только ДНС

Сам в этом толком не понимаю. Кто что скажет?

Это как придти на авторынок и вам посоветуют лимузин. А нужен был трудяга трактор или вообще газель, но вы этого не сказали никому, а лишь — «Сам в этом толком не понимаю»

По цене примерно 50+- 5 т.руб.

Да, в принципе жесткий диск и ссд на 240 гб есть (только поменял)

Конфигуратор компьютера

Спасибо!

Меня больше уливило, зачем там сисоник…

Что, говорите, вы меня не спрашивали? Так вы и автора вопроса тоже не спрашивали перед тем, как залить ему в уши свое очень важное мнение. Так что давайте, беритесь за пяльцы.

своим как то дал телефон поиграть так теперь не могу отбить их от игр.

Игры это наркотик такой же как и алкоголь как и табак.

мало того. к нам на работу стали поступать сотрудники после вузов нового поколения (так сказать новых образцов), так вот парень программист сидит сайт нам обслуживает — он не может монитор подключить к системному блоку! «монитор Карл».

за то задрот 5го разряда.

я забрал от своих.

а ютуб это вообще страх энд ужас. и дети это впитывают.

я понимаю что такое отклонится от выполнения задачи, просто забить и сказать я не могу, но этот монитор ему подключали и он ему нужен был для работы, т.е если бы он его не подключил то тупо сидел бы за более древним монитором.

i5-8500 — 18k

Asus B360 — 6.5k

8ГБ DDR4 2666 — 3.5k

GTX 1050 Ti — 11k

1ТБ HDD — 3k

120ГБ SSD — 2.5k

Корпус с БП — 2k

но вопросы гарантии как решать? весь системник отправлять?

i5-9400F OEM — 14k

DEEPCOOL GAMMAXX 200T — 1k

ASRock B360M Pro4 — 5.7k

корпус — 2.5-3k

2x8 ГБ DDR4 2666 — 7.4k

256ГБ SSD -— 3.5-4k

1ТБ HDD — 3k

Thermaltake TR2 S 550W — 3600

GTX 1060 6GB — 20k

Комментарии:

— проц чуть послабее, но для игр хватит за глаза, а отказ от встроенного видео сэкономит тысячу рублей

— кулер дешевле и лучше боксового

— материнка небольшая (я люблю маленькие корпуса), а Pro4 — лучшая серия у асрока по соотношению цена/возможности

— 8 гигабайт, на мой взгляд, игровому компьютеру впритык, я бы взял 16, но можно взять 2*4 на первое время, а в будущем докупить ещё

— корпус вещь субъективная, смотрите, чтобы кулер влез по высоте… я бы смотрел на Thermaltake Versa под mATX, а дальше по вкусу (внешний вид, наличие бокового окна)

— SSD, как мне кажется, лучше взять на 250-256 гигов… потому что и на рабочий стол хочется навалить кучу файлов, а места много не бывает

— БП, конечно, чуток избыточен, но, когда он не нагружен «впритык», то и работает тише, и жффективность повыше

Как уже писал корпус, хдд и ссд на 240гб уже есть. Без них по цене 51,7 т.р. Самое то!!!

Даже на новую мышку останется)))

Потому как последний пункт — это нечто явно нерациональное и отстойное.

Не разбираетесь — возьмите с собой товарища который разбирается. Потому как в интернете посоветуют хрень (ниже пример сборки от dartraiden даже комментировать не хочу), а потом в магазине всеравно окажется что чего-то нет в наличии и впарят что есть.

Корпус — да пофиг, хоть гроб какой с авито а 200р, хоть новую трэшатину гламурную баксов до 50 (без бп), хоть что-то приличное ($70-500), но брать блок в составе корпуса за 2000 точно не стоит.

Стоит брать какой-нибудь младший Seasonic ватт на 500, если жаба жмет — то тогда Chieftec/Highpower. Цена только блока питания под эту сборку — 50+ баксов. Упомянутое ниже Thermaltake, особенно TR2 — оверпрайснутый мусор, есть и относительно годные модели, но цена у них неадекватная и вообще стремный бренд.

По остальному — нет смысла что-то советовать, потому как всеравно в итоге хрень случается в 100% случаев у тех кто не разбирается в вопросе.

itc.ua/articles/pk-mesyatsa-yanvar-2019/

на сайте каждый месяц выкладывают несколько конфигураций на разный бюджет под Интел/АМД.

Если с этой сборки убрать корпус, хдд и ссд которые уже есть, то как раз около 50 тыр получается.

Еще один дурацкий вопрос. Что лучше Intel или AMD? И если можно, то в двух словах чем именно?

Просто раньше себе брал интел, а сейчас слышал мнение что качество интел снизилось, а амд подтянулся

еще интел где-то просчитались, и были проблемы с обеспечением спроса, поэтому интел считается сейчас дороже, а у амд есть интересные предложения. но это надо самому изучить вопрос и решить, что лучше

Для игр лучше более мощные ядра, потому что 8 ядер мало кто умеет утилизировать, 6 хватит с головой, а там уже начинает рулить тот, у кого ядра мощнее.

Ещё и в частоте памяти будет разница. Если Intel себя прекрасно чувствует на 2133 или 2666 (а выше 360-й чипсет и не умеет), то с AMD разница между памятью 2133 и 3000 МГц составит примерно 10% производительности. Ну и AMD можно разгонять, в то время, как у Intel разгоняемые процы стоят совсем уж неприличных денег.

Спасибо!

Цитата с сайта Галакс. «Из того, что было «Galaxytech», мы теперь представляем вам «GALAX» „

Галакс никакого отношения к Палиту не имеет и не имел!!! Не путайте с Гейнвард!

Из-за предвзятого отношения цена на нее ниже, а работала она с постоянным контролем температуры, постоянной температурой без перегрева, в отличие от геймерских карт (тут надо сделать отступление, возможен вариант, что к майнинговой карте относились небрежно, но в то же время такое отношение ко всем геймерским), работающих в режиме постоянного изменения температуры от комнатной до перегрева.

Потому что помещение НЕ жилое с кондиционированным воздухом, охлаждённым.Если майнер поставит кондиционер то прогорит на бабки только по электричеству.

Ну и использование не БЫТОВОЕ 5 часов в сутки а промышленное 24/7/12 мес.

Но школьники же об этом не знают!

Ещё они типа «не знают» что майнеры гоняют бытовые карточки в промышленном режиме с ПОСТОЯННОЙ максимальной 100% нагрузкой с бытовым охлаждением расчитанным на периодическую НЕ постоянную нагрузку видеоигр 50/50.

Кароче-выше в постах лапша на уши от майнеров.

Не бита не крашена не майнена.Берите наши карточки! Они самые самые… лучше новых.Они же постоянно РАБОТАЛИ!

С разгоном и перегревом.

Первым делом майнер настраивает кривые охлаждения карт так, чтобы температура при любом раскладе не превышала 60-65 °C. Для этого в том числе используется так называемый андервольтинг (undervolting) — т.е. снижается напряжение работы чипа, что влечет за собой значительное снижение температуры под нагрузкой (в ряде случаев до 10 °C).

Таким образом, видеокарты работают в щадящем режиме, при постоянной нагрузке и температуре. Непрерывная работа сводит к минимуму количество перезапусков, что означает меньшее количество переходных процессов, как электрических так и тепловых (сжатие — расширение платы, приводящее к нарушению контакта чипа с BGA подошвой и платы).

Далее, чаще всего ферма — это открытый корпус, а значит, на картах меньше копится пыль и грязь, они регулярно прочищаются, так как это, элементарно, легче.

В итоге пролучаем, что майнинговые карты, при условии что за ними следили, гораздо более предпочтительны на вторичном рынке, чем любые геймерские, которые установлены в закрытых корпусах, работают время от времени в максимальных режимах, не чистятся годами и страдают от неграмотного разгона без андервольтинга, не говоря уж об отсутствии правильно реализованной циркуляции воздуха в корпусе системного блока типичного геймера (корпуса часто устанавливаются под столом или в углу).

Единственное, что действительно страдает в картах во время майнинга, это стоковые вентиляторы, так как они, являясь механической системой, расчитаны на определённый ресурс работы, который при непрерывном режиме заканчивается гораздо быстрее. Но эта проблема решается за 500-700 рублей приобретением переходника для БП и пары-тройки качественных вентиляторов и их закреплением на радиаторе карты любым доступным способом.

Расскажу про себя. Для развлечения имел дома на балконе ферму 4х1066. Дык вот эти 1066 температур выше 60-ти градусов не видели, и раз по полгода чистились и смазывались (благо, вентиляторы в палитах достать можно пальцами). А в это время в компе стояла gtx 750, которая и 90 градусов под танками периодически видела, и троттлила иногда в более серьезных играх. Но в майнинге не участвовала никогда. А теперь внимание, вопрос — какую карту вы бы у меня приобрели, будь такая необходимость, при условии, что я вам чесно сказал, что карты после майнинга?

Зыж написал же, что при необходимости купить именно б\у.

Потому что 99% моих задач перекрывает встроенное видео.

Какую вы там информацию собрались кондиционером стирать? Нифига не понял, учитесь выражать свои мысли понятнее…

А по поводу помещений, я рад, что вы там бываете. Вопрос в том, бывали ли там сервера, описанные выше по треду. Но, чукча походу ни разу не читатель, по этому и логику он нот дететктед.

попросил его и мне заодно прикупить одну. Поскольку он разрешил мне выбрать любую, я протестировал 9 штук на предмет разгона без повышения напряжения. Составил табличку, четыре карты гнались с приличным отрывом одну взял себе а с других трех списал номера т.к. был разговор что года через 3 он будет апгрейдить ферму и я прикуплю у него вторую для SLI. В итоге ферму он решил ликвидировать уже через 1.5 года, он позвонил и предложил видюхи по очень вкусной цене.Приехал к нему, нашел ту карту тестировал, те частоты уже не берет, вторая тоже, и третья. В номинале работают. Проверяю домашнюю разгон все тот-же, хотя сын каждый вечер в игрушки на ней играл…. Полагаю что это все-таки деградация электролитов а не чипа, но положение дел это не меняет майнинг ушатал карты больше чем игры. И у него действительно карты не перегревались условия эксплуатации были близкими к идеалу в отличии от его соседа у которого фермы в съемном гараже, который к тому-же протекал, летом там было абсолютно не возможно находиться из за влажности и температуры.

Сейчас всё стало лучше?

На сервере матери

Сервер ОЗУ

Сервер проц.

И майнинг видюхе.

Накидать ссылки для сборки. И ценник.

У него всё равно моник 1280x1024 и более широкий он не хочет.

ууу Вася, да ты попал, минус 20-30% производительности

Насколько мне известно потеря будет, но в районе 3-5%.

на панде по 50-70% кто мешал брать НОВЫЕ 1060\1070

Ах да, тут же еретики про панду люто молчали и минусили 3 месяца

Но только не на такую с модифицированным биосом )))

ну не нравится вам зелёная фирма, зачем так выражаться?

А вообще есть какой-то способ/ы определить использовалась ли для майнинга или нет б/у карта, ведь продавец может и умолчать или наврать при покупке.

Наверное пора уже внедрять в видеокарты что-то наподобие счётчика пробега или т.п. которая как-то фиксировала «пробег» карты, ну или типа VIN как в машинах, или уже? :)

Пробег ничего не даст, больше даст количество циклов нагрев — остывание, и все равно это не панацея.

Аналогия с лампочкой, которая светит постоянно — работает годами.

И бумагу на вас в прокуратуру.

Врёте опять нагло.Современная лампочка в коридоре постоянно рботает 300 часов.

Годами работают лампочки 1914 года выпуска.

Опять майнер лапшу развешивает.Типа не знает что такое нароботка в часах.Как от температуры зависит старение РАЭ.

И чем бытовые приборы отличаются от промышленных.

linustechtips.com/main/topic/1029382-hacking-nvidias-drivers/?page=9&tab=comments#comment-12375554

но разбирайтесь сами, у меня такого железа нет

То есть, если эта модель легально продаётся в РФ, то и нотификация уже есть, можно ввозить дальше.

«описан способ установки P106-100» — как говориться «где, покажи, ткни» (это не наезд, это отсылка)

и честно говоря я не нашел, по редактированию реестра, что бы не нужно было изменять драйвера.

это оно? overclockers.ru/blog/Atalex/show/3345/Aktivaciya_skrytyh_vozmozhnostej_videokart_NVidia_cherez_reestr

Без модификации драйверов можно обойтись, поддержка DirectX включается ещё одним ключом реестра. Но при этом не будет поддержки PhysX, поэтому мне больше нравится способ с модификацией, который я и рекомендую в обзоре. Да и в чём проблема один раз модифицировать драйверы и один раз их поставить?

спасибо за ответ)

Я отреверсил драйвер и нашёл код, который читает AdapterType (и в зависимости от его значения взводит некий флаг), но его нейтрализация ничего не дала, поэтому я пришёл к выводу, что это код мёртвый, оставшийся от былых времён, а где конкретно сидит защита идей больше нет. Нужно сравнивать соседние версии дров (где защиты ещё нет, и где она уже есть).

К сожалению, такая удобная штука для анализа различий бинарников, как BinDiff у меня не работает, вываливаясь с ошибкой «не удалось запустить дизассемблер», а способы преодоления проблемы, найденные в интернетах, не помогли. Сейчас мне нужен человек, обладающий IDA Pro 7.2, только с этой версией работает новейший BinDiff 5, а в публичном доступе этой иды нет. Либо такой человек найдётся, либо рано или поздно в паблик сольют IDA Pro 7.2 (или новее) и я продолжу.

Ещё одним перспективным направлением является изучение кода дров на предмет активации поддержки аппаратного кодирования NVENC, но пока нет времени и идей.

Панель NVIDIA не запускается — говорит нет монитора.

Отличия от инструкции:

— Винда 10, но домашняя

— в биосе (MB-Asus z270-p) для RC6 нет варианта «авто», есть вкл и выкл. Поставил enable, соответственно.

— вывод на монитор через hdmi

Прошу помощи.

(делаю чисто для эксперимента)

ПКМ по раб.столу → Параметры экрана → Настройки графики.

Там нужно выбрать exe-шник игры и выставить ему «Высокая производительность». Оно будет рендериться на NVIDIA, а выводиться через Intel.

Есть идеи?!

P.S. Руками перебрал настройки в панели управления nvidia, везде выставил свой ГП, везде высокую производительность или управление драйвером Nvidia или приложением. Один фиг… Блин!

Need help!!!

А версия винды какая?

Сейчас уехал из дома. Вернусь — попробую запустить в своей системе новый Эксодус. (Винду на другой ссд ставил, игру на хдд, сейчас вернул прежний ссд)

Вот драйвер, который я использовал (кастрирован по максимуму: удалена телеметрия, поддержка ShadowPlay и вообще всего, кроме самого видеодрайвера и PhysX). Хотя, у вас явно проблема не с драйвером…

В биосе достаточно лишь выставить встроенное в CPU видеоядро в качестве основного адаптера (Render Standby не влияет на работу системы, влияет только на запуск, без него у меня иногда компьютер не выдаёт изображение вовсе при включении).

Причем прикол: в ПУ Нвидиа делал — не фурычит, сделал через настройки графики с параметров экрана — заработало )))

Спасибо, dartraiden!

Теперь можно убирать тестовый ссд и ставить на основной с заменой rx570 на р106 (в бенчмарке она чуть лучше показала себя)

Попробуйте драйвер, я просто добавил в nvaci.inf идентификаторы карт

NVIDIA Tesla V100-SXM2-16GB

NVIDIA Tesla V100-SXM2-16GB-LS

NVIDIA Tesla V100-FHHL-16GB

NVIDIA Tesla V100-PCIE-16GB

NVIDIA Tesla V100-PCIE-16GB-LS

NVIDIA Tesla V100-SXM2-32GB

NVIDIA Tesla V100-SXM2-32GB-LS

NVIDIA Tesla V100-PCIE-32GB

Надеюсь, у вас какая-то из них, других V100 не нашёл.

Перед установкой драйвера зачистить всё, что связано с NVIDIA, чтобы в диспетчере болталось устройство без драйверов. Ну и testsigning, конечно, включить, всё как описано в обзоре.

Если нет, то напортачили с драйвером.

Если поддержка PhysX не важна (я что-то уже давно не встречал игр с PhysX), то не нужно трогать драйвер, можно обойтись правкой реестра.

Есть еще хитрая опция в биосе — igfx multi monitor. включение или выключение её дает эффект только при отключенной в диспетчере устройств встроенной видюхе. при включенной опции нагружается р106, при отключенной опции все работает в пошаговом режиме, при этом gpu-z говорит, что пытается работать отключенное встроенное видео.

Получается, если есть встроенное видео — оно и мощное, и энергосберегающее. А если нет встроенного видео — то по умолчанию включается Р106.

На Intel, кстати, iGPU Multi Monitor включать необязательно.

Стало быть, Windows 10 не для вас. Либо семёрка с костылями, либо Linux, там всё работает «из коробки» в Steam.

Если просто поставить дрова на обе карты, все работает. В настройках АМД тоже есть разделение на разные видеокарты по производительности и есть привязка приложений к определенной карте, но эта опция, насколько я смог понять из инета, появляется только при наличии второй рабочей видеокарты. То есть, пока не появится поддержка DirectCompute у Р106. У меня данная поддержка появляется после удаления строки adaptereType из реестра. И сразу после этого после перезагрузки отваливаются настройки АМД, при попытки запустить настройки radeon с рабочего стола вываливается окно, что видеокарта не установлена или работает некорректно. Смена графических профилей АМД тоже не работает. Я думаю, вот как раз это отсутствие возможности изменить настройки и блокирует все попытки переключить работу системы на Р106. Если ли способ добавить DirectCompute не трогая adaptereType?

Видеокарта по-прежнему жива, ежедневно используется для игр и прекрасно себя чувствует.

ссылка

впрочем, довольно геморройно

1. Винда только 10. На семерке был положительный результат, но бубна хватило ненадолго, работоспособность зависела от погоды на Марсе, UltraMon больше пакостил, чем переключал экраны.

2. Сборка винды не менее 1903, причем нормально запустилось на версии корпоративной LTSC. На 1806 Р106 даже не выходит из idle при запуске приложений.

3. Дрова 417.22 ванильные.

Последовательность запуска:

1. Установка винды, предварительно отключив от инета, иначе понаставит драйверов на все, потом придется делать лишние телодвижения с DDU.

2. Установить ванильные 417.22.

3. Правка реестра: устройство 0000 не трогать, в устройстве 0001 изменить EnableMsHybryd на 1, AdapterType на 1. После этих правок заработает панель Nvidia и появится DirectCompute.

4. В панели Nvidia установить по умолчанию высокопроизводительный процессор Nvidia.

5. В параметрах экрана -> настройке графики добавить приложения, которые будут запускаться с Р106.

6. Перезагрузить. Поставить GPU-Z, контролировать там частоты и загрузку P106 в процессе игр для индикации, что все нормально работает.

7. Подключить сеть, дать винде установить все драйвера. Затем сделать откат драйверу встроенного видео до универсального видеоадаптера. Можно и просто удалить устройство, затем туда встанет по умолчанию универсальный видеодрайвер и затем виндовс подгрузит уже родной драйвер, но у меня так и не получилось запретить операционке устанавливать родной драйвер на встроенное видео. Поэтому проблему решил откатом.

Игры запускаются без проблем, не надо никаких режимов окон. Правда создалось впечатление, что FPS уперлось в цифру 20-25 и выше не подымается независимо от настроек графики.

Так что, ещё один вариант — дуалбут, поставить какую-нибудь Pop!_OS, а в неё Steam, Lutris…

Как и написано, с overridesub

Покажите скриншот GPU-Z

Впрочем, кулеры всё равно замедлились бы не до комфортных значений (заметно тише, но в играх шумновато). Проще настроить кривую вентиляторов через Afterburner.

nvflashk вообще какая-то странная штука: вшить в один GPU прошивку от совсем другого (допустим, в 1060 прошивку от 1070) он не может. Похоже, там автор лишь пропатчил неотключаемые проверки на PCI ID mismatch и так далее (там 3 проверки, но финальное решение о том, залить ли прошивку, принимает сам GPU). Прикол в том, что я это сделал года на 2 раньше, когда искал способ прошить P106-100 прошивкой от 1060. Только не думал, что это кому-то нужно и интересно, поэтому даже публиковать не стал.

Брал с Techpowerup самую свежую на тот момент официальную, непатченную.

Из минусов — не будут работать некоторые игры с античитами (типа Valorant).

а можно эту карту поставить в пару к другой gtx1060, нормальной, чтобы они вдвоем работали совместно в играх?

а ещё, следую вашей инструкции, драйвер пропатчился, но не подписался, было такое? и не ставится без подписи.

Нужно смотреть, что батник пишет, на чём споткнулся. Он в этом случае пишет, что пошло не так и ждёт нажатия любой клавиши, чтобы пользователь мог прочитать.

1) требуется драйвер строго версии 446.14 (это самый последний, где ограничение ещё можно было снять)

2) у карт должны совпадать первые три символа Device ID.

Таким образом, если у вас GTX 1060 с DevID 1B83, то не судьба, а вот если 1C04 или 1C06, то должно сработать.

а можете выложить пропатченные драйвера nvidia, которые у вас установились для этой платы в Win10?

Скорее всего, будет что-то типа PCI-E 1.1 x4. Это в 32 раза меньше, чем у реальной 3080 (у которой PCI-E 4.0 x16), отсюда и просадка. Исправить это невозможно, это аппаратное ограничение.

Даже P106-90, которая является аналогом всего лишь GTX 1050Ti, страдает от такой урезанной шины, а 3080 это намного более производительная карта и ей пропускной способности шины не хватает катастрофически.

github.com/illario7/P106toPlay/issues/1

Как я уже говорил, даже 1060 теряет 10% производительности из-за порезанной шины, а у более старших карт шина урезана ещё вчетверо (!)

Нужна твоя помощь, как человека, который понимает как всё это работает.

Уже неделю бьюсь каждый вечер до ночи, с установкой драйвера по твоей инструкции, перелопатил множество похожих статей, но видимо исходная идет от твоей. Карты CMP30, новые, год назад поработали месяц, в топку их не хочется, хочется пристроить, чтобы дети хотя бы с играми побаловались. Как только не устанавливал, вручную, авто, разные дрова (новые, старые), правил реестр, удалял и менял значения как описано(EnableMsHybryd,AdapterType), все что можно делал, ни разу не появились все описываемые поддержки в GPU-Z. Ставил как CMP 30 — пару галочек появляется в GPU-Z, но не те которые нужны. Ставишь вручную как 1660 Super, вообще нет галочек, по нулям. Винда определяет их отдельно, тут все норм. Иногда с ошибкой (горит воскл знак), чаще после правки реестра, иногда переустановишь, все ок, без ошибок. При всем этом, чтобы я не делал, панель NVIDIA отсутствует почти всегда, в авто режиме устанавливаешь, она есть, но она пустая — всё не активно, перезагрузишь и ее нет.

В чем ошибка моя? На что нужно обратить особое внимание?

Уже дело принципа, надо дожать) Я уже начинаю грешить, что не правильно патчу дрова или это надо делать только по нечетным дням недели, ну либо ретроградный меркурий, больше вариантов у меня нет.

Винда 10 Pro — версия 190…

Материнская плата -ASUS TUF GAMING B450-PLUS II Socket AM4 AMD B450

Проц — AMD Ryzen 3 со встроенным видео.

А это не помогает?

Скачав всё это, отключите сетевой кабель, почистите старые дрова с помощью DDU с перезагрузкой (сетевой кабель нужно отключать, чтобы Windows не качнула и не поставила драйвер сама в промежутке между удалением старого и установкой нового), затем ставьте (вручную с выбором GTX 1660 SUPER).

Вообще, смысла играть на CMP-картах я не вижу, там чудовищно урезана шина.

Нет, это все перечисленное не помогает, от слова совсем… про интернет все прекрасно понимаю, DDU тоже, все сделано по инструкции, раз по 20-ть. Почему не помогает, сказать сложно, не понимаю.

Но решение нашлось, помощь пришла откуда не ждал) Коллега по работе который сидит по соседству с моим столом- Китаец, я ему жестами и картинками минут 10 объяснял суть проблемы, КАРТА-МАЙНИНГ-НЕ РАБОТАЕТ КАК ИГРОВАЯ -ХОЧУ ЧТОБЫ ЗАРАБОТАЛА-НУЖНЫ ДРОВА. Он сказал ОК, через 5 минут поисков по китайским сайтам, скинул мне просто экзешник 531.29 (просто один экзешный фаил), сказал ничего шаманить не надо, запускаешь и кайфуешь. Я долбался больше недели, проглатывая инфу с Ютуба и разных сайтов, шаманя с настройками и биосом, а у него это заняло 5 минут. Установился драйвер с какой-то ошибкой в конце, тем не менее, все за

Но, у меня мои малые рубятся в ФОРТНАЙТ, играть невозможно, лагает жестко, просадки с 60 Fps до 20Fps даже на минималках. Погонял на бенчмарке, результат показывает как у GTX1060 а не GTX1660 Super.

есть старенькая GTX1050, поставил ее, она держит Fps стабильнее 60 с просадками до 50.

Пока разочарован, урезанная шина дает о себе знать и не плохо. Если есть у кого идеи как улучшить ситуацию в играх, делитесь).

Скорее всего, конечно, там ровно те же самые пропатченные dll, ну, может, ещё и inf-ы подправлены.

Добрый день!

Не понял как тут на форуме выкладывать файлы, да и чет я сомневаюсь уже, что это форум, похоже на торговую площадку каку-то)) Прикрепил ссылку на яндекс диск.

Вот, кстати, более свежий

Придумай что-то с пропускной способностью шины, как увеличить? Или тут только проц менять на Ryzen 5 5600g минимум?

Без разницы, подведено к слоту 8 линий PCI-E 3.0 или 16 линий PCI-E 4.0. Этот видеочип может использовать лишь 4 линии PCI-E 1.1, таково аппаратное его ограничение.

В любом случае, спасибо тебе за твои труды.

www.youtube.com/watch?v=twRIYq2p-38 (где-то в районе 8:50)

На выходе получится PCI-E x16 1.1. Что, конечно, всё равно не очень много, но таки в 4 раза больше, чем было.

на древнем 775 сокете, где эта шина ещё поддавалась разгону, и смог кой-чего достичь. Базовая частота шины PCI-E — 100мГц, я смог поднять её до 112мГц без ущерба системам материнской платы. Шину можно гнать и вплоть до 130мГц, однако при этом система перестаёт инициализировать Ethernet и SATA контроллеры материнки (Полагаю, они завязаны на PCI-E). Результат: в бенчмарках Furmark и MSI Kombustor прирост производительности составил 12%, кратно увеличению частоты шины. Способ конечно извращенный, но рабочий. В игрушках особо не тестировал, разве что в Far Cry 5 с минималками при FullHD прирост составил 7-9 кадров. Карта у меня P106-090, черт пойми какого вендора, на зотаковском биосе. Шина у неё 4x. Наблюдал ещё один странный феномен, что после разгона шины Power Limit видеокарты стал невзначай сильно превышать свои 75 ватт, скачет порой до 85-90 ватт

На днях выложу, если будет время, я засел кардинально перерабатывать патчер, чтобы отказаться от глючной китайской утилиты и попутно закинул несколько багрепортов в проект osslsigntool.

Насчёт второго вам виднее (может, у вас стоят какие-то программы для автообновления драйверов или Geforce Experience), а что касается Windows Update, то в статье приведён ключ реестра, отключающий обновления драйверов.

Кроме того, вы можете попробовать запретить обновление не всех драйверов, а лишь драйверов для конкретного устройства. В этом случае, никто, ни Windows Update, ни сторонние утилиты, не смогут обновить драйвер. Обратите внимание, что галку «применить к уже установленным устройствам» взводить не нужно, потому что задача не снести текущий (пропатченный) драйвер, а предотвратить его замену в будущем.

В будущем, возможно, удастся перейти на самостоятельно созданные сертификаты, тогда патчер снова оживёт и никакие блокировки страшны не будут. Но пока до этого ещё далеко.

Он собственно и говорит, что это «рискованное ПО, подписано фейковым сертификатом» — и это чистая правда, сертификат фейковый, покупать нормальный сертификат за 500 баксов в год я точно не собираюсь :)

С последними драйверами должно работать даже без процессорной встройки, если, конечно, есть вторая видеокарта для вывода картинки.

Поэтому читать нужно ридми в ветке master, либо читать эту статью на муське, в комментах к которой мы сейчас находимся, где пошагово написано, как теперь жить дальше, а именно — использовать уже пропатченные мной файлы.

Победил, перепрошил биос на свежий, появился пункт, включил одновременную работу встройки и дискретки, буду пробовать ставить драйвер

Отвечающих за него электронных компонентов нет на плате? Нет поддержки в BIOS, а накатить BIOS от обычных «игровых» карт мы не можем? Проблема с драйверами?

Купил себе 106-100 с прицелом на аппаратное ускорение в jellyfin (или plex), но, разумеется, не работает.

Перед покупкой плохо исследовал вопрос и подумал, что раз игры запускает, значит и видео будет считать.

Есть сведения, что на картах линейки CMPXX NVENC работает после патча. Пока об этом отписались всего лишь два пользователя. На картах линейки PXXX, применение этого патча приводит к тому, что программы видят поддержку NVENC, но при попытке использовать его — падают.

А на процессорной встройке нельзя аппаратно кодировать? Intel QuickSync (не знаю, что там у AMD)

Встречал по интернету буквально еще пару упоминаний, что в картах физически отсутствует компонентная база для NVENC, но бездоказательно. Еще на паре форумов люди начинали пробовать двигаться в направлении активации NVENC, но больше сообщений от них не было. Надеюсь, с ними все хорошо =)

Думаю, если бы у них получилось, то тема была бы достаточно развита, хотя бы на уровне инструкций по запуску игр на этих видеокартах, но в интернете вакуум(

Попробую накатить патч, на который вы указали. Всё равно эта карта или под тесты или в мусор, т.к. ими авито завален с ценой 1.5к и они просто никому не нужны.

p.s. у AMD кодер называется AMD AMF.

Накатывать ничего не надо, всё уже накачено, достаточно выбрать архив с префиксом NVENC-

1.у тебя на гитхабе когда нажимаешь на ссылку что бы скачать патченые драйвера, тебя перебрасывает на страницу на которой можно скачать файл с подписью оригинальные драйвера, так должно быть или я что то не понимаю?

2.правильно ли я распаковал патченные/оригинальные файлы для драйвера

3.после DDU у меня горит восклицательный знак в оранжевой обводке а у тебя в красной

4.после открытия Install.bat с правами администратора командная командная строка просто закрывается

5. как лучше всего устанавливать драйвера?

изображение с распакованными файлами для драйвера в папке с драйвером

строчки которые я удалил:

:CheckAdminRights

net session >nul 2>&1

if not %ErrorLevel% == 0 (

echo Please run as administator^^!

pause

exit /b 1

)

2,4,5) Драйвер распакован некорректно, отсюда и все проблемы. В моём архиве лежит Install.bat и папка Display.Driver, вот их и нужно положить в корень. Вы зачем-то из Display.Driver вытащили файлы в корень.

3) Можно пропустить этап с DDU, но при установке драйвера обязательно выбрать опцию «чистая установка».

Сразу предупреждаю: драйвер сейчас имеет проблемы с античитом FaceIT. Вообще, бороться с античитами я не подряжался (и возможностей бороться у меня почти нет), но в ближайшие дни постараюсь что-то сделать.

В конце там нашли решение.

Карта от Gigabyte — GV-NP106D5-6G

Шина в GPU-Z PCIe x16 1.1 @ x4 1.1

Это мне так с моделью «повезло» или я что-то не так сделал?

Плата — GA-H81M, проц E3-1275v3

На более новых картах (CMPXX) это решается распайкой недостающих элементов возле слота, может, и тут подойдёт.

Работает без проблем со встроенным видеоядром в процессор. Киберпанк и и пабг идут c вполне приличными кадрами (40-100к/сек).

Подскажите пожалуйста, возможно ли запустить СМР40НХ в связке с GTX1030, для вывода изображения через GTX1030? Простая установка карты и патченых драйверов, ничего не дала, в настройках графики, пропадает возможность выбора видеокарты.

Тогда одна будет высокопроизводительной, а вторая энергоэффективной. Какое значение какой карте соответствует, определите экспериментально, я плохо помню.

Если не получится, читайте github.com/dartraiden/NVIDIA-patcher/issues/57 до конца.

О результатах, пожалуйста, сообщите.

Это зависит от поколения процессора и интерфейса на материнке, да.

Это кто-то или что-то ставит официальный непатченный драйвер, поэтому и название становится родное, и все игровые возможности отключаются.

— попробуйте не включать опцию про подмену названия

— тестовый режим не нужен

Теперь другой вопрос, а это нормально, что в PUBG уже на стартовом экране слайдшоу из 17 кадров? Хотя видеокарта загружена более чем на 90%. Пробовал разные версии Directx.

i7 4970k, 8gb ОЗУ, P106-100

Загрузку тоже лучше смотреть в GPU-Z

Можно ради интереса попробовать драйвер 417.22

— установить (оригинальный)

— в HKEY_LOCAL_MACHINE\SYSTEM\ControlSet001\Control\Class{4d36e968-e325-11ce-bfc1-08002be10318} найти подраздел, соответствующий P106-100

— удалить там ключ AdapterType

— создать там же параметр EnableMsHybrid типа DWORD32 и присвоить ему значение 1

— передернуть P106-100 в диспетчере устройств

— в панели управления NVIDIA выбрать P106-100 в качестве адаптера по умолчанию

Система такая: 2500k, мать P67(нет поддержки интегр видео), gtx 560 ti.

Поскольку нет Sync мода на P чипсете «подружить» дрова от 560 и 106 я не могу. Есть смысл патчить дрова 560-ой или я всё равно упрусь в ограничение мамки???

Минимально, чтобы всё работало, как задумано — 4 поколение Intel, а у вас второе.

Но почему-то обороты кулера на максимум.

Ни афтербернер и прога от асуса, ни перебор биосов не помогли. Кулеры всегда на 100.

Может у кого есть идеи почему так?

Моя реагировала на Afterburner.

Если это P106-100, то в посте есть ссылка на биос, на котором кульки ведут себя немного потише (впрочем, для меня это было всё равно шумновато).

Asus B85M-K

Intel Core i3 4600

Ram 12 Gb

iGpu Intel HD4400

P106-100

Windows 10 1903

Покупал у себя в городе, обошлась примерно в 1250 рэ, задавать вопросы продавцу по типу не майнилась не стал, слушать бред про не майнилась не хотелось. Начал поиск внятной инструкции по установке дров и последующего запуска ВК. Много разных ответов от гугла было, пробовал разные дрова, официальные, патченые, ВК не хотела запускаться. Восклицательный знак ДУ, на встройке и на ВК, в биосе ставил сначала авто на графику, потом на встройку делал. Видяха после выключения тест режима всё равно была с восклицательным знаком. Много обзоров/инструкции посмотрел, и вот на каком то из обзоров скачал дрова патченые каким то китайцем. Ниже мои действия

1. Скачал дрова, DDU. Включил тест режим. В биосе включил графику со встройки, память авто, рендер оставил без изменений.

2. Перезагруз в тест режим, удалил дрова нвидиа, установил патченые дрова от китайца, видяха включилась в работу, но пока в тест режиме. Встройка с восклицательным знаком и ошибкой 12, нет ресурсов.

3. Отключил тест режим и перезагруз. Дрова встройки и карты с восклицательными знаками. Дальше пошёл курить гугл, танцевать с бубном.

4. По запросу мать Асус и видяха увидел инструкцию, всё то же самое, но, в биосе настройки графики, видяха встройка, память 64 Мб вроде, рендер без изменений.

5. Включаю тест режим, перезагруз, захожу в биос ставлю как описано, встройка, память выделяемая для графики 64, рендер не трогаю. Гружусь в тест режим.

6. Чищу дрова нвидиа и снова ставлю патченый файл от китайца. Встройка с восклицательным знаком, карта работает, GPU-Z показывает что все норм с картой.

6. Отключаю тест режим, перезагруз, держу пальцы скрещенными и смотрю на часы, надо спать, завтра на работу, но хочется добить дрова до работоспособности. Загрузка раб. стола, иду в ДУ, встройка и карта без восклицательных знаков(урааа), запускаю GPU-Z все норм.

Да этого стояла затычка GT 730, Ведьмак 3 закрывался после кат сцены. Запуск на этой карте успешен, настройки пока средние выставил. Играет все норм, фпс не проверял.

вместо человеческого компьютера у меня древний сервер на 1366, поэтому я надеялся выводить картинку через 650ti

я удалил дрова через ddu, поставил 472.12 (в которые закинул соответствующий архив с гитхаба) через install.bat, а после удалил 650ti в диспетчере устройств (по другому назначить p106 как высокопроизводительную у меня не вышло)

в итоге всё работает, кроме дх 12 :(

я неправильно понял инструкцию и дх12 не светит на старом железе вне зависимости от наличия второй видеокарты? или просто что-то не так сделал?

ощущение, словно хорошо работает только всякое старьё, в которое я и на 650 поиграть мог (пусть и на низких)

www.nvidia.com/ru-ru/drivers/geforce-gtx-650ti/#pdpContent=2

Точнее, оно обозначается как 12 (11_0), т.е. программно, но не аппаратно.

Попробуйте китайский драйвер, чем чёрт не шутит. К тому же, он слегка новее.

большое спасибо, похоже драйвера помогли!!! некоторые проблемы с производительностью остались, но наверное здесь уже дело в райзере для 650

рад как ребёнок, большой вам почёт за то что всё ещё поддерживаете всё это в рабочем состоянии

у меня cmp 30hx 551.23 driver

Установить, как обычно: запустить и следовать инструкциям (когда спросит, какой метод подписи выбирать, выбирайте второй)

Ничего не поделаешь, у меня нет лишних нескольких тысяч долларов в год на нормальную подпись…

Установка

Вот на примере 560.81 как называется оригинальный .exe studio и game ready:

560.81-desktop-win10-win11-64bit-international-dch-whql.exe (game ready)

560.81-desktop-win10-win11-64bit-international-nsd-dch-whql.exe (студио драйвер)

У китайского драйвера буква «s» в именах файлов тоже есть.

Собственно, только этими файлами драйверы и отличаются (остальные отличия косметические), а бинарники вообще идентичны.

Посмотрел несколько inf наугад — никаких оптимизаций не вижу, лишь поддержка кучи карт из Studio вырезана, в т.ч. майнинговых (китайцам, видимо, пришлось их заново добавлять).

Сдаётся мне, что разница в играх, например, если и будет, то на уровне погрешности.

На реддите тоже пишут, что ключевая разница — частота обновлений. Studio обновляются реже, а Game Ready чаще, чтобы игруны получали свежие исправления для игр.

Повторюсь, двоичные файлы идентичны, отличие только в текстовых inf. Сомнительно, что там какие-то глубокие оптимизации. Просто тем, кто работает, важнее стабильность, а игрунам важнее новые исправления под свежие игры.

Все работает. Есть скролл но из за 6600 gt

Один пользователь недавно приватно сообщил, что минимальная версия драйвера для ATI/AMD — 16.2.1, соответственно, нужна видеокарта хотя бы серии HD 5000, потому что более старые карты этот драйвер не поддерживает.

С таким драйвером ему удалось завести карты в паре даже на 775 сокете.

Я с этим сделать ничего не могу, т.к. у меня, во-первых, нет лишних тысяч долларов в год на кошерную подпись, а даже если бы и была, разработчики античитов всё равно руками добавляют сертификаты в базу античита и вряд ли они бы стали мой сертификат добавлять в доверенные.

Проблема в целом нерешаема, поскольку античиты не пускают кого попало взаимодействовать с игрой, а я в их глазах, разумеется, «кто попало».

В руки попалось китайское чудо GTX1080 с китайским драйвером 377.35, с ним работает без проблем, но новые игры ругаются на старые дрова. Если установить новые = черный экран.

Можно ли по какой-то методике пропатчить новые драйверы, чтобы с этим чудом их подружить?

Вот, прикрепляю.

377.35 китайский

Я в мобильную тематику никогда не совался, там свои нюансы.

Это невозможно по той же причине, по которой не существует редакторов биоса. Прошивки подписаны цифровой подписью, при её нарушении GPU откажется работать.

Почему не работает Afterburner — не знаю. Если есть время, можете попробовать попрошивать прошивки от других карт (избегайте тех, где объём памяти не равен 6), может, на какой-то прошивке будет работать регулирование вертушек через AB.

www.techpowerup.com/vgabios/?architecture=Uploads&manufacturer=&model=P106-100&interface=&memType=&memSize=&since=

www.techpowerup.com/vgabios/?architecture=Uploads&manufacturer=&model=P+106-100&interface=&memType=&memSize=&since=

www.techpowerup.com/vgabios/?architecture=Uploads&manufacturer=&model=P106-100+6GB&interface=&memType=&memSize=&since=

www.techpowerup.com/vgabios/?architecture=Uploads&manufacturer=&model=p106-100+v2&interface=&memType=&memSize=&since=

Либо как-то резать провода, идущие к вертушкам и колхозить в разрыв резисторы. Когда-то таким народ занимался с корпусными вентиляторами, которые не умели регулировать обороты. Добавление резистора снижало скорость.

Пока не могу решить с запуском minecraft (tlauncher). Игра упорно использует ЦП, хотя hd3000 отключена в диспетчере. Остальные программы удаётся направить через ГП. Кстати, Roblox, так же сопротивляется ))

Может ещё есть какие варианты решения.

3dnews.ru/1006819/obzor-amd-ryzen-5-3400g-i-ryzen-3-3200g

Мучаюсь уже сутки с проблемой.

Комплектующие ПК:

Материнская плата: Gigabyte GA-A320M-S2H V2

Процессор:Ryzen 3 2200G

Оперативная память:16 GB 2666gHz

Видеокарта:VEGA 8

Накопители (HDD/SDD):SSD kingson 120 GB

Блок питания:Ginzzu SB-600

Сис-ма охлаждения:BOX AMD

Windows: 10 ltsc x64

Uefi обновлен до последней версии.

Свть проблемы:

Пришла карточка ASUS MINING P106-100 V2

Воткнул, поравил UEFI BIOS накатил все как в инструкции всй норм, дрова встали.

Пошел тестить а в тестах везде упор в FPS 20-25.

Обратил внимание что в GPU Z Bus interface PCIe x16 1.1 @x1 1.1

Т.е. шина pcie работает x1.

Что пробовал:

Ставил в uefi csm,pcie gen3, сброс делал, режим forces.

Протыкал все параметры в pcie в энергосбережении Шидовс.

Перевтыкал карту в мат плату.

Поставил последний драйвер который выложен был в 02.00 24.05 (час назад)

Ничего не помогает.

Мб есть решение для этой проблемы???

Нашел на гитхабе такаюже проблему:

github.com/dartraiden/NVIDIA-patcher/issues/261

Мой ТГ: S1OVVE (на всякий случай если кто знает как решить вопрос или желает помочь, тк этот сайт не очень удобен для общения)

Собираю комп младшему брату

Пасыба!

После первых тестов (где FPS так-же был 20-25) прошил биос видеокарты на тот, что закреплен в этой теме.Прошивка стала, всё ок, вертушки больше не молотят на 50%.(но всё также шина X1 1.1)

Еще хотел добавить что есть 2 карты:

GT 440 (лежит без дела)

RX 570 8gb Saphire (в основном компе)

Тээээээкс

навел я конечно шороху но решить проблему всё таки удалось.

Вот статья в которой описана моя проблема и ее решение.

club.dns-shop.ru/discussions/t-99-videokartyi/572804-nvidia-gpu-rabotaet-tolko-v-rejime-pcie-x1-vmesto-pcie-x8/

Мне помогло обновление BIOS UEFI материнской платы.

поставил версию [F30] 2019-04-17 дата выпуска

стояла [F57g] 2025-03-23

Басыба

Если есть вариант добавьте в FAQ статьи

А что насчёт Topaz Video AI? Владельцы cmp90hx, проверьте бенчмарк, запускается ли?

Либо использовать 7-zip, который без проблем всё распаковывает.

Либо в репозитории почитать Readme, где указана ссылка на архив со всеми старыми версиями.

Есть несколько вопросов, т.к. собрав данные отсюда и с гитхаба, у меня не всё получилось.

У меня CMP30HX Win10-22H2

1. Какой драйвер выбирать для модификации (декстоп или ноутбучный) на сайте Хуанга?

2. На гитхабе есть модификация для 581.94, но у Хуанга не нашёл такой драйвер, можно ссылку, где смотреть? Использовал Advanced Search

3. Сделал мод версии 581.57, всё установилось, но не было выбора смены названия ВК. Где это должно произойти?

4. В Панели управления нВидиа есть только пункт Управление счётчиками производительности", других меню нет. Как выставить приоритет ВК для игр?

5. Пробовал устанавливать nVidia App, но оно застывает на вечной загрузке мелкого окна посередине и не даёт доступа к настройкам.

2. Я же ссылку даю всегда. Слова «Download original driver package.» это кликабельная ссылка. Этот драйвер — хотфикс, поэтому он поиском не находится. Но по сравнению с предыдущим (который находится), в нём исправлены проблемы с производительностью в Windows 11, поэтому использовать лучше именно его.

3. Выбора имени давно уже нет, оно нормально не работало. Если хотите сменить имя, то непосредственно перед запуском инсталлятора (после замены файлов моими) в nv_dispi.inf поменяйте в конце файла название на желаемое.

4. Возможно, NVIDIA это убрала. Лучше использовать Windows 11, там в настройках ОС есть этот выбор.

5. И не даст, его сменой названия видеокарты не обманешь, оно на DeviceID смотрит.

4. Пока не очень хочется на 11 переходить. Других способов переключения, например, через реестр, нет?

P.S. В этом паблике нашёл репак драйвера 581.94, установил его на Win10 и в Панели управления всё появилось, как надо. Причём ссылаются они на вас :) Было бы отлично знать, как они получили такую сборку, чтобы в будущем самостоятельно делать такие сборки. Хотя в комментах автор паблика пишет, но на Win10 всё равно куча проблем, так что буду тестировать. В крайнем случае буду искать чистую сборку Win11 без мусора и телеметрии.

Если да, то все файлы идентичны тому, что вы получите, взяв официальный дистрибутив и заменив файлы моими. Там нет отличий. Причина изменений в «Панели управления», стало быть, в чём-то ином.

Возможно, пока вы устанавливали драйвер в первый раз, Windows. обнаружив, что драйвер отсутствует, успела подкачать и поставить свой.

Процессор xeon 1275-v3 и p106-100 увидел что нельзя установить на такую мать драйвер с p106-100 (было написано позже) вопрос как всётаки установить драйвер на нее? Типо я установил по гайду у меня встройка процессора в диспетчере устройств с желтым треугольник и не поменять разрешение не герцовку не могу, понель nvidia не открывается пишет что не подключено к гп, в добавок параметры hd graphics не устанавлюваются с драйверами…

И да, это почему-то именно на асусах. Мне неизвестно, чтобы кому-то удалось с этим что-то сделать.

Windows 11, драйвера устанавливал 472.12, 581.94, выбрал в настройках графики nVidia/

Игры и бенчы вываливаются или в BSOD или на рабочий стол. Afterburner/RivaTuner при запуске ругается, что не могут внедриться в Direct3D12

существует ли решение для такой ситуации?

А ещё бывают сами карты полудохлые после майнинга.

Материнская плата GIGABYTE GA-H77M-D3H

Процессор Intel Core i5-3570

CMP30HX X16 Gigabyte

Драйвера модифицировал все ок, в ДУ отбражается 1660 Super

Через FurMark все летает 100+ кадров в FullHD.

Но как только запускаю игры, работает все через встройку.

В реестре в ветке Компьютер\HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\Class\{4d36e968-e325-11ce-bfc1-08002be10318}\0001

Перекинул Содержимое из ветки 0000 в 0001 — OpenGLDriverName и OpenGLDriverNameWoW

C:\Windows\System32\DriverStore\FileRepository\nvaci.inf_amd64_ac3d51b71f86c632\nvoglv64.dll

C:\Windows\System32\DriverStore\FileRepository\nvaci.inf_amd64_ac3d51b71f86c632\nvoglv32.dll

не помогло. Игры запускаются только на встройке.

Помогите пожалуйста, сутки уже мучаю железо )